Czym jest "Big Data"

W świecie analityki pojawiło się nowe pojęcie, nowy kierunek - "big data". W skrócie pojęcie to oznacza tendencję do poszukiwania i wykorzystania wartości biznesowej drzemiącej w dostępnych coraz większych wolumenach danych. Pochodzą one z niezliczonej liczby miejsc, często spoza organizacji, z obszarów do tej pory zupełnie niekwalifikowanych jako źródła informacji istotnych dla podejmowania właściwych decyzji biznesowych (jak np. media społecznościowe). To naturalna kolej rozwoju biznesu i ewolucja, której de facto należało się spodziewać. W publikacjach i literaturze odnaleźć możemy także dodatkowe określenie równoważne w wielu aspektach z ideą "big data" - jest to High Performance Analytics.

W przeszłości wystarczała wiedza o działaniu organizacji, poszukiwaliśmy przewag biznesowych w dobrej organizacji procesów biznesowych (np. produkcyjnych) poprzez wdrożenia systemów ERP oraz raportowanie operacyjne. Kolejnym krokiem było poszukiwanie trendów w posiadanych zbiorach danych, analizowanie przyczyn zachodzących wydarzeń - tak rozwijał się obszar wdrożeń systemów Business Intelligence i tak powstawały pierwsze hurtownie danych. Wiązało się to także z ewolucją platform baz danych i zaczęły powstawać specjalizowane narzędzia analityczne służące odkrywaniu takich wzorców.

Wtedy wkroczyliśmy w erę konkurowania analityką (ang. "competing on analytics"). Zaczęliśmy przewidywać zachowania naszych klientów (np. prognozowanie prawdopodobieństwa odejścia klienta, tzw. churn) oraz optymalizować nasze działania, szczególnie łańcuchy logistyczne oraz działania marketingowe oraz cenniki naszych usług i produktów. To jednak we współczesnym świecie nie wystarcza. Pojawiają się nowe trendy, gdzie analizie poddajemy także dane niestrukturalne - przykładem jest tzw. "text mining" lub analiza wizerunku w mediach społecznościowych, które znacząco rozszerzają zakres wiedzy niezbędnej do podejmowania właściwych decyzji biznesowych.

Ze względu na złożoność systemów ekonomicznych, w których funkcjonują największe firmy trzeba zauważyć, że łańcuch wartości, jaki chcą one dostarczać klientom znacząco się wydłuża. W tej chwili zwykłe promowanie produktu już nie wystarcza. Poszukujemy ciągłego wznoszenia się w piramidzie identyfikowanej przez "experience economy"1 zmierzając w kierunku dostarczania nie tylko usług i produktów, ale kompletnego zestawu doświadczeń, które pozwalają na oczekiwanie wyższych marż i lojalności od naszych klientów. Takie rozbudowanie łańcucha wartości rozszerza zakres informacji, z którymi na co dzień musimy się zmierzyć w procesie podejmowaniu decyzji.

Z drugiej strony oferta, którą kierujemy na rynek, produkt lub usługa, jest coraz bardziej złożona, ulega silnej personalizacji, jest wynikiem współpracy wielu ludzi i podmiotów. Złożony produkt i usługa opracowywana w spersonalizowany sposób to także dodatkowy aspekt zwiększający ilość informacji z tym związanych. Dodatkowo pamiętajmy, że informacje te nie pochodzą tylko z wnętrza naszej organizacji (gdzie teoretycznie możemy nad nią zapanować, wpływać na jej strukturę i proces pozyskiwania), ale także spoza firmy. Trzeba umieć do nich się dostosować, jeżeli chcemy z nich skorzystać.

Podsumujmy nasze nowe środowisko funkcjonowania:

- wysoki wolumen danych wynikający ze złożoności procesów, personalizacji oferty i tendencji dopasowania oferty nawet do najmniejszych grup klientów,

- nieznane pochodzenie, struktura i zawartość danych, których będziemy chcieli użyć w analizach,

- duża zmienność danych w czasie wiążąca się z dynamiką i złożonością modeli ekonomicznych, w jakich funkcjonują przedsiębiorstwa.

Pojawia się jeszcze jedno zjawisko - analiza informacji i danych jest już powszechna w organizacjach. W dowolnym miejscu podejmowania decyzji pracownicy biznesowi oczekują możliwości analizy szerokiego zakresu danych, oczekują zaawansowanych metod analitycznych i umieją z nich skorzystać. Czy warto? Tak.

Na silnie nasyconym rynku, gdzie klient ma realną możliwość wyboru, umiejętność zwiększenia trafności podejmowanych decyzji zaledwie o pojedyncze procenty (bez względu jak rzeczywiście wskaźnik ten zostanie obliczony) może decydować o sukcesie lub porażce. Firmy muszą być przygotowane do tego, aby na każdym kroku poszukiwać dodatkowych korzyści, oszczędności lub przewag. Źródłem niezbędnej wiedzy są i będą bardzo duże wolumeny danych z wielu nieskorelowanych źródeł - dodatkowo, czego nauczyliśmy się już wspierając systemami informatycznymi zaawansowaną analitykę, nie mogą to być dane zagregowane. Właściwą wiedzę uda się pozyskać tylko z danych detalicznych.

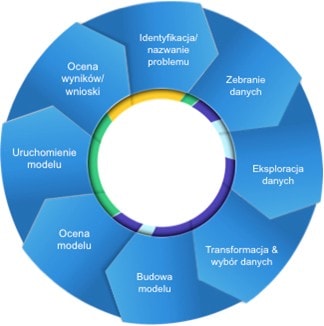

Prześledźmy przykładowy proces wnioskowania - jest on osadzony w standardowym przepływie od sformułowania problemu, poprzez zebranie koniecznych danych, przygotowanie modelu analitycznego i ocenę wniosków z niego wynikających.

Źródło: SAS Institute

Jak widać na przykładzie powyżej przeprowadzenie skutecznego wnioskowania wspierającego rozwiązanie sformułowanego na początku problemu biznesowego wiąże się z jednej strony z wykorzystaniem szeregu informacji, wymaga możliwości poszukiwania korelacji pomiędzy zbiorami danych nigdy dotąd nie krzyżowanymi oraz jest procesem często zmieniającym stawiane hipotezy i wymagającym częstego opracowywania nowych zestawów danych wspierających analizę danego scenariusza.

Istniejące środowiska hurtowni danych, analityczne i raportowe są w stanie wspierać ten proces, lecz dynamika jaką są w stanie dostarczyć nie będzie dla pracowników biznesowych wystarczająca. Wkraczamy w erę "big data" i należy się do niej przygotować.

Oczekiwania użytkowników

Każde działanie mające na celu rozbudowę lub rozwój środowisk informatycznych powinno być realizowane w świetle korzyści, jakie dane rozwiązanie ma dostarczać organizacji. Bezpośrednio powinno oddziaływać na procesy biznesowe oraz użytkowników, a pośrednio dodatnio przekładać się na realizację strategii firmy i osiąganie przez nią wzrostu.

Wiemy już w jaki sposób zmienia się sposób pracy pracowników biznesowych firm. Ale jakie są ich szczegółowe oczekiwania? Jako punkt wyjścia należy przeanalizować, w jaki sposób zmienia się ich oczekiwanie dotyczące interakcji z informacjami i danymi.

Standardowe podejście do procesu analitycznego nie zmienia się i nadal składa się z następujących po sobie kroków zamkniętych w cykl:

Źródło: SAS Institute

Kolejno formułowane jest zagadnienie biznesowe lub hipoteza, dla której szukać będziemy potwierdzenia. Następnie identyfikowane i przygotowywane są dane, które zostaną wykorzystane do analizy, budowany jest model analityczny. Po jego ocenie i uruchomieniu następuje zebranie wniosków i może to bezpośrednio prowadzić do sformułowania kolejnych hipotez, jak pokazuje to przytoczony wcześniej przykład.

Mapując pokazany proces na rzeczywiste zaangażowanie zasobów ludzkich i sprzętowych znacząca część zużywana jest na cykliczne powtarzanie iteracji w obszarze zbierania i przygotowania danych do budowy modelu. Na etapie jego oceny dochodzimy do wniosków, że konieczne jest zrezygnowanie z zastosowanych agregacji (wykorzystanie danych detalicznych), rozszerzenie wybranej próbki danych do uruchomienia modelu, dołączenie nowych miar i wymiarów dla poprawienia spodziewanej jakości przeprowadzanej analizy. W aktualnie istniejących środowiskach hurtowni danych i systemów analitycznych zamknięcie takiej iteracji jest pracochłonne i wymaga czasu. Na to w bieżącej sytuacji nie można sobie pozwolić.

Główną potrzebą i celem użytkowników biznesowych jest przeniesienie ilości realizowanych iteracji w obszar budowy modelu i wnioskowania na jego podstawie (czyli patrząc na przytoczony diagram przeniesienie ciężaru działań z prawej na lewą stronę cyklu). To w tych etapach cyklu analitycznego znajduje się wartość biznesowa i to na tych etapach pracownicy firm pozyskują unikalną, nieznaną dotychczas, wiedzę o funkcjonowaniu biznesu, zjawiskach na niego się przekładających i czynnikach koniecznych do uwzględnienia w przyszłych działaniach.

Oczekiwaniem analityków jest z jednej strony możliwość nieograniczonego testowania swoich hipotez, ale także dostęp do szerokiego zestawu funkcji i narzędzi analitycznych. Kadra pracownicza, która jest odpowiedzialna za podejmowanie decyzji biznesowych i jest wykształcona w zakresie analityki, statystyki i pracy ze zbiorami danych - oczekuje, że firma (potencjalnie dział IT) dostarczy im możliwość wykorzystania nabytych umiejętności z korzyścią dla efektów swojej pracy. Oczekują natychmiastowej reakcji wykorzystywanych narzędzi na stawiane przed nimi zadania:

- włączania nowych danych do analiz bez względu na ich wolumen

- możliwości wykorzystania w analizie danych detalicznych (w końcu nie jest znany czynnik biznesowy, którego poszukują analitycy)

- praktycznie natychmiastowego odpowiadania na stawiane pytania, wyników uruchamianych analiz i możliwości oceny wniosków wynikających ze zbudowanych modeli

Podsumowując można powiedzieć, że analitycy i pracownicy biznesowi organizacji oczekują przeniesienia ciężaru z pracy z danymi na pracę koncepcyjną - i taka idea przyświeca budowie środowisk realizujących koncepcję "big data". Nieograniczonej swobody w analizie danych.

Jest jeszcze jedna nowa tendencja wkraczająca do świata biznesu wymagająca zaadresowania - użytkownicy oczekują dostępu do informacji i analiz w każdym miejscu i o każdym czasie. Jest to powodowane upowszechnieniem mobilnego dostępu do sieci komputerowych i pojawieniem się rozwiniętych urządzeń mobilnych (smartphone, tablet). Jeżeli chcemy, aby użytkownicy byli zadowoleni z dostarczonego dla nich środowiska analitycznego zadbajmy także o ten aspekt i dokonajmy wyboru narzędzi dających synergię dostępu do analiz bez względu na wykorzystywane do tego urządzenie - komputer stacjonarny, laptop, tablet lub telefon.

Składniki środowiska "big data"

Powyżej omówiliśmy perspektywę użytkowników środowisk realizujących koncepcję "big data". Warto zagadnieniu przyjrzeć się także z perspektywy działów IT odpowiedzialnych za zapewnienie istnienia i sprawnego funkcjonowania takiego środowiska. Aktualnie IT jest równoprawnym partnerem dla pracowników biznesowych w budowaniu przewag konkurencyjnych przedsiębiorstwa i partycypuje w odpowiedzialności za osiąganie przez nie zysków. Dzięki podejmowaniu działań optymalizacyjnych w aspekcie kosztowym, efektywności systemów i usług, przyszłościowym planowaniu rozwoju infrastruktury sprzętowej i systemowej oraz doświadczeniu merytorycznym pracowników, dział IT nie jest tylko jednostką usługową, ale wchodzi w skład arsenału strategicznego na coraz bardziej konkurencyjnym rynku.

Zagadnienia i aspekty obrazujące oczekiwania analityków można poddać strukturalizacji i wyodrębnić 4 główne role w pętli procesu analitycznego:

- manager w obszarze biznesowym - podejmuje decyzje na bazie wniosków z analiz, ocenia procesy i określa potencjał korzyści biznesowych,

- eksplorator danych - odpowiada za procesy udostępnienia danych dla procesów analizy, ewentualnie wzbogaca dane o dodatkowe wyliczane miary, definiuje powiązania pomiędzy zbiorami danych pozwalające na ich korelowanie w trakcie analiz,

- analityk biznesowy - formułuje i testuje hipotezy biznesowe; odpowiada za zbudowanie, uruchomienie i ocenę działania modelu analitycznego lub badania statystycznego prowadzonego na danych; wyciąga wnioski z uzyskanej wiedzy,

- projektant analityk - przygotowuje wizualizacje i raporty ułatwiające uzyskanie wymaganych informacji z analiz, korzysta z wyników pracy analityków biznesowych tworząc cyklicznie wykonywane analizy na potrzeby wsparcia procesów biznesowych.

Zwróćmy uwagę, że rolę eksploratora danych z powodzeniem realizować może departament odpowiedzialny za IT w organizacji. De facto coraz częściej okazuje się, że w zadaniach tej klasy kluczowe jest doświadczenie informatyczne i znajomość narzędzi transformacji i składowania danych uzupełnione wiedzą o systemach źródłowych.

Budowa systemu informatycznego realizującego koncepcję "big data" powinna być realizowana w świetle powyższych ról. System analityczny powinien posiadać narzędzia adresujące poszczególne z powyższych ról i spełniające ich specyficzne potrzeby, między innymi:

- być efektywny i elastycznych w zakresie ładowania dużych wolumenów danych oraz wykonywania na nich złączeń i wzbogacania (eksplorator danych)

- posiadać komplet funkcji analitycznych będących narzędziami w pracy analityków biznesowych

- szybko odpowiadać na zadawane pytania i realizowane analizy usprawniając pracę analityków i projektantów

- umożliwiać tworzenie interaktywnych analiz danych dostarczanych także na urządzenia mobilne (projektant analityk)

Z perspektywy rozwiązań technologicznych aktualnie dostępne na rynku są narzędzia realizujące trzy koncepcje:

- przetwarzanie danych w pamięci (ang. in-memory)

- przetwarzanie danych realizowane przez silnik bazy danych (ang. in-database)

- przetwarzanie równoległe realizowane przez sieć komputerów (ang. grid computing)

Każde z powyższych rozwiązań skupia się na maksymalizacji korzyści z jednego, konkretnego aspektu stosowanej architektury, a co za tym idzie ma swoje mocne i słabe strony. Przetwarzanie w pamięci potencjalnie dostarcza większą wydajność i krótsze czasy przeliczania zadań i modeli, za to realizacja analityki w powiązaniu z bazą danych (szczególnie w przypadku dedykowanego sprzętu bazodanowego, tzw. ang. appliance) daje optymalizację wykorzystania mocy sprzętu równocześnie dla przetwarzania danych oraz ich analizy.

Pamiętajmy także, że wiele dostawców rozwiązań wspierających ideę "big data" oferuje swoje produkty w powiązaniu z konkretnym dostawcą sprzętu, niekiedy będąc nim równocześnie. Zbudowanie systemu analitycznego na bazie takich rozwiązań to strategiczna decyzja uzależniająca organizację od jednego dostawcy sprzętu i równocześnie uniemożliwiająca skorzystanie z już posiadanej infrastruktury. Tu także musimy pamiętać o przeprowadzeniu oceny zdolności środowiska do elastycznego skalowania i ocenić koszty jego rozbudowy.

Oferta SAS łączy korzyści wszystkich wskazanych strategii technologicznych, dając możliwość zarówno wykorzystania mocy serwerów do wykonywania obliczeń bezpośrednio w ich pamięci, jak i skorzystania z udostępnianych przez serwery baz danych funkcji analitycznych. W odniesieniu do rozwiązań SAS warto zwrócić uwagę na dodatkowy aspekt - jest to możliwość budowy węzłów przetwarzania danych z wykorzystaniem sieci komputerów (ang. grid computing). Daje to możliwość dowolnego skalowania rozwiązania wraz ze zmianami potrzeb biznesowych oraz dodatkowo gwarantuje odporność środowiska na ewentualne awarie. Wszystkie te strategie złączone zostały w jedną spójną architekturę, przez co możliwe jest dostarczenie użytkownikom końcowym jednego systemu analitycznego odpowiednio wykorzystującego mocne strony każdej ze strategii przetwarzania dla zwiększenia wydajności platformy.

Skuteczny pomost pomiędzy IT a biznesem

Wszystkie przedstawione powyżej zagadnienia należy wziąć pod uwagę w momencie konstruowania strategii dostarczenia w organizacji systemu analitycznego wspierającego nowe podejście do analizy danych - "big data". Departament IT może wykorzystać posiadane doświadczenie z budowy i utrzymania istniejących systemów analitycznych w formowaniu tej strategii. Powstające platformy powinny uzupełniać korporacyjne hurtownie danych. Ich architektura logiczna, wykorzystane do ich budowy narzędzia oraz procesy biznesowe związane z zarządzaniem zmianą w tych środowiskach wymagają dobrze zaplanowanej i przemyślanej rozbudowy, aby móc skutecznie realizować wymaganie dynamicznego analizowania nowych hipotez biznesowych.

Systemy "big data" służące analizie wielkich wolumenów danych wzbogacą istniejące hurtownie o nowe funkcjonalności udostępniane użytkownikom. Ich zalążki już znajdują się w organizacjach w formie rozproszonych repozytoriów tworzonych bezpośrednio przez analityków. To co należy teraz zrobić, to dostarczyć im wysokiej klasy rozwiązanie informatyczne, aby mogli utylizować z jego pomocą drzemiący w nich potencjał kreacji nowych rozwiązań biznesowych. IT może z powodzeniem dostarczyć tą wartość, tworząc unikalny pomost między technologią a biznesem i rozbudowując istniejące architektury hurtowni danych o nowe komponenty realizujące ideę "big data".

1. "Experience economy" autorstwa Josepha Pine II oraz Jamesa H. Gilmore

Informacja o autorze: