Architektura nowoczesnej platformy analitycznej

Dynamicznie rozwijający się świat analityki zdominowało nowe hasło - "big data". Poza szeroko znanym trzem (lub nawet czterem) "V" skojarzonym z tym hasłem, samo "big data" to także szansa na zbudowanie rozwiązań informacyjnych odpowiadających na zmieniające się potrzeby użytkowników systemów. Dostępność technologicznych rozwiązań przetwarzających szeroki strumień danych (Volume) o bardzo dużej różnorodności (Variety) i dynamice (Velovity) przekłada się dzisiaj na możliwość kreowania unikalnych wartości biznesowych (Value).

Skuteczne wplecenie "big data" w powstające lub ewoluujące architektury informacyjne organizacji powinno być osadzone w perspektywie możliwości ich wykorzystania - czyli w modelu wykorzystania systemu informacyjnego przez samych użytkowników. Ten za to, równocześnie z rewolucją techniczną, także przechodzi przemianę. Wzrost świadomości odbiorców przekłada się na zmianę dotychczasowego zadania dostawcy. Nie budujemy już rozwiązań pod klucz - dostarczamy platformy wspierające modele samoobsługowe nakierowane na współpracę oraz stymulowanie innowacji w działaniu i wnioskowaniu.

Przełamana została dodatkowo bariera dostępności informacji. Wszechobecne systemy wspierające pracę operacyjną są trwale połączone z centralnymi rejestrami, a także zostały wzbogacone o rozwiązania bezpośrednio komunikujące się z obywatelami (np. zapisy do szkół, system ZIP). To jeszcze bardziej zwiększa natłok informacyjny, stanowiąc jednocześnie podstawę skutecznego wyciągania korzyści z analizy tych danych. Jak w tak dynamicznym środowisku zbudować fundament nowoczesnej platformy analitycznej? Postaram się odpowiedzieć na to pytanie.

Klasyczne hurtownie danych i kojarzone z nimi metody zarządzania z wykorzystaniem informacji przechodzą strukturalną przemianę. Dzisiaj prowadzona przez nas działalność, a co najważniejsze także nasi pracownicy, oczekują od nas zupełnie innego podejścia. Czasy, kiedy integracja danych była najważniejsza, kiedy ścierały się paradygmaty Kimballa i Inmona, są już historią. Istniejąca technologia pozwala na wiele więcej i rynek wymaga wiele więcej.

Business Intelligence, hasło znane nam już ponad 40 lat, kojarzy się przede wszystkim z określonymi modelami dostarczania wartości biznesowej. Raporty i analizy służą nam do prognozowania zjawisk biznesowych, czy też wskaźników naszej efektywności i rentowności. Data mining ujawnia ukryte w danych wzorce, umożliwiając wykrywanie sytuacji niepożądanych, identyfikowanie nadużyć, ale także profilowanie zachowań naszych klientów i dostosowywanie własnej oferty i sposobu działania do ich oczekiwań. Optymalizacja pomaga nam podejmować właściwe decyzje, nawet w najbardziej złożonych modelach ekonomicznych, a analiza tekstu, stosunkowo młoda dziedzina, znajduje wzorce w danych niestrukturalnych, wzbogacając istniejące analizy o nowe predyktory.

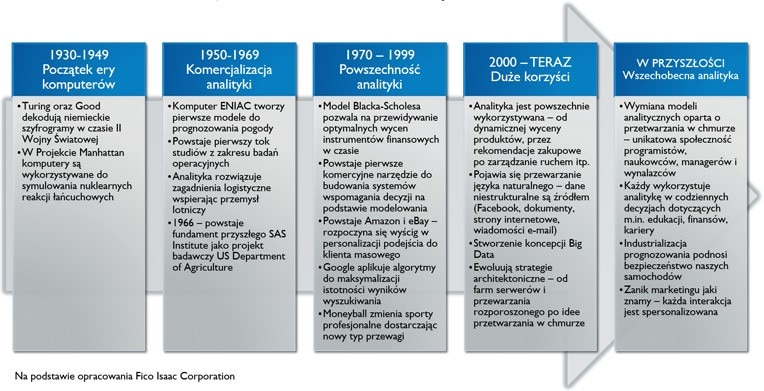

Jak do tego doszliśmy? Gdzie stosujemy analitykę i "business intelligence"? Wszystko zaczęło się od zastosowania maszyn komputerowych (bo raczej należy te urządzenia nazywać maszynami) w projektach takich, jak budowa bomby atomowej. Po raz pierwszy zastosowano wtedy komputery do symulacji zjawisk fizycznych (symulacja reakcji łańcuchowych). Pozostając nadal w zastosowaniach rządowych komputery w latach 50-tych pozwalają na poprawę prognoz pogody. Nie jest to jeszcze poziom porównywalny z dzisiejszymi możliwościami, ale jest jednakże zastosowaniem pro publico bono. Dopiero pod koniec XX wieku wspomaganie decyzji wkracza do świata biznesu. Możemy nawet powiedzieć, że właśnie wtedy, analityka ulega komercjalizacji. Powstają pierwsi giganci - Amazon, Google. To oni doskonałą metody, których dzisiaj używają wszyscy w swojej działalności, zmierzając do jak najlepszego profilowania klientów i dzięki temu zwiększania swojej sprzedaży (nawiązując do poprzedniego slajdu to właśnie tu stosowany jest data-mining). Analityka wkracza także do świata sportu - słynny Moneyball, gdzie skład drużyny baseballu decydowany był w oparciu o matematykę i statystykę. Ten moment zmienił trwale całą dziedzinę sportu.

Dzisiaj analityka daje nam niezmierzone korzyści, wyzwala nowe modele biznesowe i powoduje, że nasze życie jest łatwiejsze. Współczesna ekonomia, nawet pomimo kryzysu wywołanego jej niedoskonałościami, bazuje na analizie danych i informacji. Treści, które kierują do nas media (w tym także społecznościowe) dobierane są specjalnie do profilu naszych zachowań, a każdy dojrzale myślący przedsiębiorca komunikuje się z klientem detalicznym starając się dostarczyć mu optymalnie dopasowaną ofertę. Banki są w stanie w ciągu godzin oceniać naszą zdolność kredytową, a instytucje takie jak BIK edukować nas, w jaki sposób na nią wpływać. Świat ogarnęła pasja zbierania i przetwarzania danych. Koncepcja Big Data dzisiaj jest dostępna już dla każdego. Co to oznacza dla naszej przyszłości? Przede wszystkim wszechobecność analityki. Analityki dostępnej w rozwiązaniach osadzonych w chmurze, współdzielonych, gdzie każdy z nas może użyć jej do wsparcia naszych codziennych wyborów - dotyczących prywatnych finansów, edukacji, kariery.

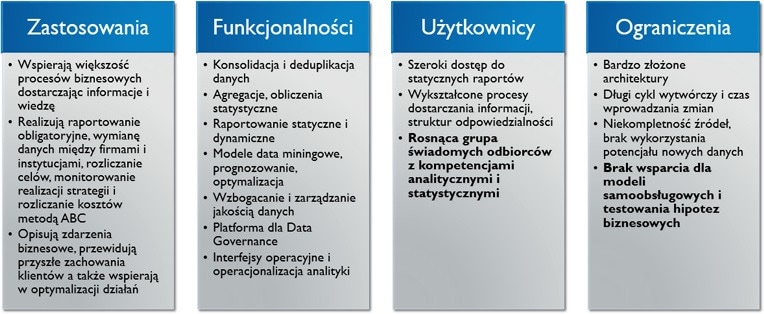

Aby dokonać tego ostatniego kroku musimy przełamać paradygmaty zastosowania i budowy klasycznych systemów hurtowni danych, business intelligence, raportowych i analitycznych. Dzisiaj klasyczne systemy BI wspierają nas w szeregu zastosowań, opisują zjawiska biznesowe, sprawozdają, księgują i rozliczają. Pomagają nam właściwie komunikować się z interesariuszami i klientami. Mają bardzo rozbudowane funkcjonalności, w wielu miejscach latami dobudowywane i rozwijane. Od systemów tylko i wyłącznie przedstawiających zgromadzone dane rozwinęły się do platform zarządzania informacją, gdzie znana jest i monitorowana jakość danych, a samo korzystanie z informacji jest dojrzałym procesem biznesowym, bez którego nie przetrwała by jakakolwiek organizacja. Użytkownicy także zmienili się i dojrzeli przez lata. Każdy z nas na co dzień w pracy korzysta z raportów, przetwarza dane, ale co najciekawsze - wielu z nas chce samodzielnie budować zaawansowane analizy. Uczelnie kształcą swoich studentów z zagadnień, które jeszcze kilka lat temu zarezerwowane były dla wąskiego grona naukowców. Wiedza o metodach analitycznych i świadomość potęgi drzemiącej w informacjach przestaje być tajemna - staje się powszechna i naturalna. To Ci użytkownicy, nasi nowi pracownicy, wymagają zmian w modelu budowania hurtowni danych.

Dzisiaj także widzimy ograniczenia, z którymi borykamy się na co dzień. Architektury naszych systemów analitycznych są bardzo skomplikowane, nie są reaktywne na coraz bardziej pędzący świat. Długość cykli wytwórczych i nakłady konieczne na ciągłe zarządzanie zmianą powodują, że tracimy możliwość budowania unikalnych przewag konkurencyjnych, tracimy zdolność do innowacji zmieniającej nasze modele działania. Nowy użytkownik, o którym była mowa, oczekuje, że systemy informacyjne będą pozwalały mu na znacząco więcej samodzielności. Oczywiście nie należy zapominać, że klasyczne hurtownie danych to także bezpieczeństwo i stabilność działania - które w procesach niedopuszczających błędów są cenniejsze, niż dynamika wprowadzania zmian. Klasyczne podejście sprawdza się nadal w sprawozdawczości obligatoryjnej i w zadaniach finansowych. Wymaga po prostu uzupełnienia i wzbogacenia.

Popatrzmy przez chwilę na zmiany, jakie zachodzą w modelach ekonomicznych, na ewolucję informatycznego społeczeństwa 21-ego wieku. Nasuwający się podstawowy wniosek to fakt przewijającej się wszędzie nieustannej interakcji pomiędzy dostawcą (usługi, produktu) a odbiorcą. Ta interakcja generuje informacje i dane, które z powodzeniem można poddawać analizie, a równocześnie odbywa się na wielu platformach. Już dzisiaj możemy mieć wgląd w dane rozliczeniowe NFZ, które dotyczą świadczonych nam usług. Możemy elektronicznie zapisywać dzieci do przedszkoli i aktywnie korzystać z profili zaufanych ePUAP. Równocześnie ta interakcja jest także pomiędzy nami - konsumentami - np. z wykorzystaniem serwisów społecznościowych takich jak Waze, gdzie wzajemnie informujemy się o utrudnieniach drogowych i współdzielimy dane nawigacyjne. Dynamika, o której mowa przeniosła się też do obszaru B2B - warszawska giełda umożliwia tzw. HFT (High Frequency Trading), firmy wymieniają się elektronicznymi zamówieniami i w ten sam sposób realizują swój biznes. Klienci detaliczni zamawiają towary i usługi przez serwisy samoobsługowe, a w procesach gwarancyjnych oczekują, że serwis będzie udostępniał im informacje o postępach prac w wiadomościach SMS. W świecie mediów społecznościowych klienci podejmują swoje decyzje na bazie rekomendacji - potrafią odrzucić nawet korzystne oferty (np. banków) tylko i wyłącznie na postawie zbudowanej w mediach opinii. Równocześnie topnieje bariera ochrony prywatności i my klienci, coraz częściej dzielimy się informacjami o nas oczekując, że zostaną one właściwie zinterpretowane i ktoś wykona za nas pracę związaną z wyborem oferty, skieruje do nas komunikację właściwie skrojoną. Docelowo to właśnie inteligencja jaką będziemy prezentować w naszym działaniu przełoży się na zadowolenie interesariusza lub pozyskanie klienta.

Ten nowy, świadomy, interesariusz, czy też klient, to główny czynnik wymuszający na nas zmiany naszego działania - wymuszający na nas, docelowo dobrą ewolucję i optymalizację działań, której nie da się wdrożyć i skutecznie utrzymać bez zmiany podejścia do analityki i przetwarzania informacji. To właśnie sprawność w realizowaniu złożonych i zmiennych procesów biznesowych jest nowym polem budowania przewag konkurencyjnych oraz poszukiwania własnej doskonałości. Za tym idzie zapewnienie naszym interesariuszom poziomu usług, którego od nas oczekują.

Podsumowując stojące przed nami wyzwanie: musimy sprostać nowym oczekiwaniom klientów, zapewnić właściwe narzędzia kadrze pracowników oraz to wszystko zrealizować z zachowaniem wysokiej dynamiki działania i racjonalności kosztów. Rozwiązaniem jest implementowanie idei Big Data w naszych środowiskach informatycznych. Nie chodzi tu jednak o podważenie sensu funkcjonowania istniejących systemów hurtowni danych - one sprawdzają się, jak to już zostało powiedziane, wspaniale w obszarach stabilnych potrzeb i wymagań. Big Data powinno być rozpatrywane jako uzupełnienie takich środowisk oraz równocześnie jako idealne podejście do rozpoczęcia inicjatyw analitycznych w organizacji.

Kiedy definiowano pojęcie Big Data wskazano cztery kluczowe cechy danych i wymagań biznesowych, którym ma ono za zadanie sprostać:

- objętość (Volume) - czyli zdolność do radzenia sobie nawet z największymi ilościami danych, takimi jak dane dotyczące ubezpieczeń społecznych, zdrowia, czy też ruchu w sieci telefonii komórkowej

- różnorodność (Variety) - czyli duża ilość różnych, niekoniecznie skorelowanych ze sobą źródeł informacji, które chcemy analizować w jednym kontekście. Przykładem może tutaj być mnogość informacji, które z perspektywy funkcjonowania miasta są istotne - poczynając od ruchu ulicznego a na inwestycjach infrastrukturalnych kończąc

- dynamika (Velocity) - czyli wysoka częstotliwość, z którą dane ulegają zmianie lub aktualizacji, co jest charakterystyczne dla większości procesów zachodzących w naszych czasach

- wartość (Value) - czyli skala potencjału drzemiącego w wykorzystaniu takich danych - niezależnie, czy jest to zdolność do uzyskania dodatkowego przychodu, czy też zdolność do uzyskania oszczędności i podniesienia własnej efektywności ekonomicznej.

Te cztery obszary wpływają na klasyczny cykl analizy informacji. Każdy z nas w pewnym stopniu go realizuje - czasem w sposób bardzo sformalizowany, czasem wręcz instynktownie, bez konkretnego nazywania kroków i wskazywania czynności i odpowiedzialności.

Powyższa pętla jest naturalnym postępowaniem, gdzie w pierwszych krokach definiujemy tezę, którą będziemy badać z wykorzystaniem analityki. Następnie przygotowujemy dane i budujemy model analityczny (np. bazujący na technikach data-mining). Po jego uruchomieniu jesteśmy w stanie ocenić jego poprawność, skuteczność i podjąć na jego podstawie działania biznesowe (np. wskazać potencjalne przypadki nadużyć). Domknięciem jest rozpoczęcie procesu ponownie, bazując na skorygowanej tezie lub uzupełnionych o empiryczne wnioski dane. W każdym kolejnym przebiegu pętli uzyskujemy wyższą skuteczność i lepsze dopasowanie modelu do badanego zjawiska. Pamiętajmy także, że każde uruchomienie działań biznesowych powoduje zmianę w obiektach, które badamy analizą (np. skierowanie kampanii marketingowej do klientów powoduje, że ich skłonność do pozytywnych reakcji na przekaz już się zmienia).

Gdzie leży klucz do sukcesu? Przede wszystkim w umożliwieniu organizacji realizacji powyższych cykli częściej i taniej. To finalnie da bardzo dobre wyniki prowadzonych analiz, a co za tym idzie wysoką skuteczność podejmowanych decyzji. Kolejny istotny element, na który wdrożenie rozwiązań zgodnych z ideą Big Data przekłada się, jest proces integracji danych i samego opracowywania modeli analitycznych. Narzędzia tej klasy przygotowane są z założeniem wysokiej elastyczności dla użytkownika oraz dynamiki odpowiedzi na nowe pytania stawiane dostępnym danym. W ramach tych kroków użytkownicy będą w stanie zrealizować w bardzo krótkim czasie szereg testów poprawiających wyniki analizy, wzbogacających je o nowe dane. W ten sposób znowu podniesie się dynamika realizacji całej pętli i skróci czas od postawienia hipotezy biznesowej do podjęcia działań przez organizację.

Z powyższych rozważań można wysnuć wnioski dotyczące kluczowych cech dla rozwiązań adresujących podejście Big Data. Przede wszystkim istotna jest wydajność i szybkość - bez niej nie uda się skrócić cyklu analitycznego w organizacji. Drugim aspektem, którego należy poszukiwać w systemie jest realizowanie modelu samoobsługowego - w sytuacji, gdy oczekiwania pracowników co do dostępu do narzędzi i danych są wysokie, to bezwzględnie należy z tej okazji skorzystać i wprowadzić do infrastruktury IT rozwiązania pozwalające im na uwolnienie własnych pomysłów. Ostatecznie rozwiązania Big Data powinny być dostępne. W dzisiejszym świecie, gdzie miejscem pracy jest dowolna przestrzeń (czy to w kawiarni, czy w podróży, czy w trakcie spotkania z klientem) to i rozwiązania analityczne muszą być w nich osiągalne.

W tym miejscu trzeba także odpowiedzieć na ważne pytanie, zaznaczone już powyżej: czy rozwiązania Big Data zastąpią istniejące hurtownie danych? Nie, nie zastąpią - one je wzbogacą. Dla modeli samoobsługowych i wysoce elastycznych charakterystyczną cechą jest ich zmienność. Jeżeli nasza analityka i raportowanie ma być realizowane w sposób spójny w czasie, niezmienny i stabilny, to takie zadania z powodzeniem będzie realizować klasyczna hurtownia danych zdolna spełniać nawet najbardziej rygorystyczne SLA oraz posiadająca rozbudowany proces zarządzania jakością informacji w niej przetwarzanej.

Nowoczesne platformy analityczne - platformy realizujące koncepcję Big Data - wymagają od nas posiadania strategii ich wdrożenia, umiejętności skorzystania z nich oraz dostępności narzędzi służących do ich budowy. Wszystkie te trzy składowe na dzisiaj są spełnione. Strategię kreować będą sami użytkownicy, gdzie nowy system analityczny będzie inkubatorem ich innowacyjności, a klasyczne rozwiązania raportowe cyklicznie zrealizują w ten sposób powstałe idee. Umiejętności nasi pracownicy już posiadają, wymaga to tylko zaadresowania poprzez wdrożenia platform. Narzędzia przeszły już etap "niemowlęcy" i są dojrzałymi platformami do integracji danych, wizualizacji i wspierania użytkownika w elastycznym prowadzeniu procesu wnioskowania z zebranych danych. Pamiętajmy także, że te nowoczesne narzędzia są proste w użyciu i dostępne w każdym miejscu i na każdym urządzeniu.

Informacja o autorze: