ETL

Qué es y por qué es importante

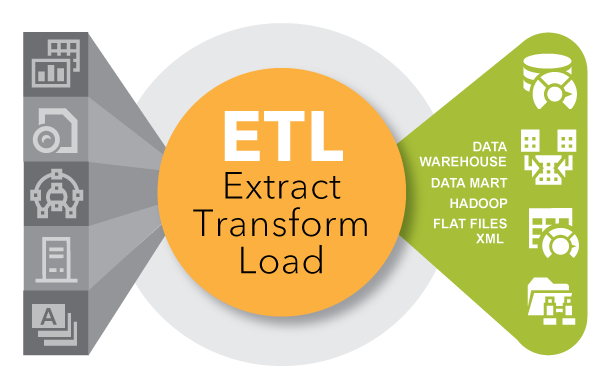

ETL es un tipo de integración de datos que hace referencia a los tres pasos (extraer, transformar, cargar) que se utilizan para mezclar datos de múltiples fuentes. Se utiliza a menudo para construir un almacén de datos. Durante este proceso, los datos se toman (extraen) de un sistema de origen, se convierten (transforman) en un formato que se puede almacenar y se almacenan (cargan) en un data warehouse u otro sistema. Extraer, cargar, transformar (ELT) es un enfoque alterno pero relacionado diseñado para canalizar el procesamiento a la base de datos para mejorar el desempeño.

Historia de ETL

ETL cobró popularidad en la década de 1970 cuando las organizaciones comenzaron a utilizar múltiples repositorios de datos, o bases de datos, para almacenar diferentes tipos de información de negocios. La necesidad de integrar datos que se diseminaran por estas bases de datos creció con rapidez. ETL se convirtió en el método estándar para extraer datos de diferentes fuentes y transformarlos antes de cargarlos en una fuente pretendida o destino.

A fines de la década de 1980 y principios de la década de 1990, los data warehouses aparecieron en escena. Siendo un tipo de base de datos diferente, los data warehouses proveían acceso integrado a datos de múltiples sistemas – computadoras mainframe, minicomputadoras, computadoras personales y hojas de cálculo. Pero diferentes departamentos a menudo elegían diferentes herramientas ETL para utilizarlas con almacenes de datos distintos. Junto con fusiones y adquisiciones, muchas organizaciones terminaban con diferentes soluciones ETL que no estaban integradas.

Con el tiempo, el número de formatos, fuentes y sistemas de datos ha aumentado enormemente. Extraer, transformar, cargar (ETL) es ahora sólo uno de varios métodos que utilizan las organizaciones para recopilar, importar y procesar datos. ETL y ELT son ambos partes importantes de una estrategia de integración de datos más amplia de una organización.

Por qué es importante ETL

Las empresas han confiado en el proceso ETL por muchos años para obtener una vista consolidada de los datos que que dé lugar a mejores decisiones de negocios. Hoy día, este método de integración de datos de múltiples sistemas y fuentes sigue siendo un componente central de la caja de herramientas de integración de datos de una organización.

ETL se utiliza para mover y transformar datos de diferentes fuentes y cargarlos en diferentes destinos, como Hadoop.

- Cuando se utiliza con un almacén de datos empresarial (datos en reposo), ETL provee profundo contenido histórico para la empresa.

- Proporcionando una vista consolidada, ETL facilita a los usuarios de negocios analizar y generar reportes sobre datos relevantes para sus iniciativas.

- ETL puede mejorar la productividad de los profesionales de los datos porque codifica y reutiliza procesos que mueven datos sin requerir habilidades técnicas para escribir código o scripts.

- ETL ha evolucionado para satisfacer requisitos de integración emergentes para cosas como los datos transmitidos por streaming.

- Las organizaciones necesitan ETL y ELT para conjuntar datos, mantener la precisión y proporcionar el recurso de auditoría que suele requerirse en los almacenes, reportes y análisis de datos.

ETL en el mundo actual

Los datos en rápido movimiento de hoy (datos transmitidos por streaming) pueden ser capturados y analizados al instante a través de la analítica de streaming. Este enfoque presenta la oportunidad de actuar de inmediato, con base en lo que sucede en un momento determinado. Pero la vista histórica que hace posible ETL pone los datos en contexto. A su vez, las organizaciones logran un entendimiento pleno de los negocios con el tiempo. Los dos enfoques necesitan operar junto.

7 consejos para modernizar la integración de datos

La integración de datos ha estado entre nosotros por años, pero sigue teniendo un rol fundamental en la captura, el procesamiento y el movimiento de datos. Siga estos consejos de TDWI que orientarán sus esfuerzos de modernización de la integración de datos.

Beneficios de una vista única del cliente

Esta compañía proveedora de energía almacenaba datos de clientes en diferentes sistemas y formatos. Con el software SAS® Data Management, la compañía depuró e integró registros, reduciendo con ello el total de registros en 25% e incrementando la integridad de los registros en 30%.

Integración de datos reinventada

En lugar de desvanecerse, las tecnologías antiguas terminan a menudo coexistiendo con las nuevas. Hoy día, la integración de datos está cambiando para estar al nivel de las diferentes fuentes, formatos y tecnologías de datos. Este documento muestra cómo mantener relevante su enfoque de la integración de datos.

SAS: Líder en el Gartner Magic Quadrant 2017

Gartner ha posicionado a SAS como Líder en el Gartner Magic Quadrant para Herramientas de Integración de Datos 2017.

Las organizaciones más exitosas tendrán una estrategia clara y precisa implementada que reconozca la integración de datos como una piedra angular fundamental de su diferenciación competitiva.

– David Loshin, Presidente de Knowledge Integrity Inc. El nuevo panorama de la integración de datos: Vayamos más allá de ETL para un fin específico hacia una estrategia de integración de datos empresarial

Software de integración de datos de SAS

El software de integración de datos de SAS distribuye tareas de integración en cualquier plataforma y se conecta virtualmente a cualquier almacén de datos de origen o destino.

Aprenda más acerca del software de integración de datos de SAS

Cómo se utiliza ETL

Las herramientas ETL y ELT centrales trabajan en paralelo con otras herramientas de integración de datos, y con otros diferentes aspectos de la gestión de datos – como calidad de datos, gobierno de datos, virtualización y metadatos. Entre sus usos populares actuales se cuentan:

ETL y usos tradicionales

ETL es un método probado al que muchas organizaciones recurren todos los días – como comerciantes detallistas que necesitan ver datos de ventas con regularidad o proveedores de atención a la salud que buscan una descripción precisa de solicitudes. ETL puede combinar y sacar a la superficie datos de transacciones de un almacén de datos a otro de modo que estén listos para que los vean personas de negocios en un formato que puedan entender. ETL se utiliza también para migrar datos de sistemas heredados a sistemas modernos con diferentes formatos de datos. Se utiliza a menudo para consolidar datos de fusiones de negocios, y para recopilar y unir datos de proveedores o asociados externos.

ETL con big data – Transformaciones y adaptadores

El que consiga más datos gana. Aunque no es necesariamente cierto, tener acceso fácil a un a una amplia variedad de datos puede dar a las empresas una ventaja competitiva. Hoy día, las empresas necesitan tener acceso a todo tipo de big data – desde videos, medios sociales, la Internet de las Cosas (IoT), registros de servidores, datos espaciales, datos abiertos o externalizados, y más. Los proveedores de ETL agregan con frecuencia nuevas transformaciones a sus herramientas para cumplir estos requisitos emergentes y admitir nuevas fuentes de datos. Los adaptadores dan acceso a una enorme variedad de fuentes de datos, y herramientas de integración de datos interactúan con estos adaptadores para extraer y cargar datos con eficiencia.

ETL para Hadoop – y más

ETL ha evolucionado para dar soporte a la integración en mucho más que data warehouses tradicionales. Herramientas ETL avanzadas pueden convertir y cargar datos estructurados y no estructurados en Hadoop. Estas herramientas leen y escriben múltiples archivos en paralelo en y desde Hadoop, simplificando la forma en que se fusionan datos en un proceso de transformación común. Algunas soluciones incorporan librerías de transformaciones ETL pre construidas para los datos de transacciones e interacciones que se ejecutan en Hadoop. ETL permite también la integración en sistemas transaccionales, almacenes de datos operacionales, plataformas de inteligencia de negocios, concentradores de gestión de datos maestros (MDM) y la nube.

ETL y acceso a datos con autoservicio

La preparación de datos con autoservicio es una tendencia en rápido crecimiento que da el poder de acceder a, combinar y transformar datos en las manos de usuarios de negocios y otros profesionales de datos no técnicos. Para un fin específico por naturaleza, este enfoque incrementa la agilidad organizacional y libera a TI de la carga de proveer datos en diferentes formatos para usuarios de negocios. Se invierte menos tiempo en la preparación de datos y más en generar insights. En consecuencia, los profesionales de datos de negocios y de TI pueden elevar su productividad y las organizaciones pueden escalar su uso de datos para tomar mejores decisiones.

ETL y calidad de los datos

ETL y otras herramientas de software de integración de datos – que se utilizan para depurar, perfilar y auditar datos – garantizan que los datos sean confiables. Las herramientas ETL se integran con herramientas de calidad de datos y los proveedores de ETL incorporan herramientas relacionadas en sus soluciones, como aquellas que se utilizan para el mapeo y el rastreo del linaje de los datos.

ETL y metadatos

Los metadatos nos ayudan a entender el linaje de los datos (de dónde provienen) y su impacto en otros activos de datos en la organización. Conforme las arquitecturas de datos se vuelven más complejas, es importante dar seguimiento a la forma en que se utilizan y se relacionan los diferentes elementos de datos en su organización. Por ejemplo, si agrega un nombre de cuenta de Twitter a su base de datos de clientes, necesitará saber qué se verá afectado, como tareas, aplicaciones o reportes ETL.

SAS® Data Management en acción

Con SAS Data Management, usted puede aprovechar volúmenes de datos descomunales – por ejemplo, datos de clientes de publicaciones en Twitter – para obtener insights como nunca antes. Matthew Magne explica la forma en que SAS puede transmitir datos de Twitter a un lago de datos, depurar y perfilar los datos, y luego revelar qué clientes tienen la mayor probabilidad de abandonarlo. A su vez, puede crear un plan para retenerlos.

Cómo funciona

ETL está íntimamente relacionado con otras varias funciones, procesos y técnicas de integración de datos. Entenderlos le provee una visión más clara de cómo funciona ETL.

| SQL | El lenguaje de consulta estructurado es el método más común para acceder a y transformar datos en una base de datos. |

| Transformaciones, reglas de negocios y adaptadores | Después de extraer datos, ETL utiliza reglas de negocios para transformar los datos en nuevos formatos. Los datos transformados se cargan después en el destino. |

| Mapeo de datos | El mapeo de datos es otra parte del proceso de transformación. El mapeo proporciona instrucciones detalladas a una aplicación acerca de cómo obtener los datos que necesita procesar. También describe qué campo de origen concuerda con qué campo de destino. Por ejemplo, el tercer atributo de un flujo de datos de actividad de un sitio Web podría ser el nombre del usuario, el cuarto podría ser el sello de la hora de cuando se llevó a cabo esa actividad y el quinto podría ser el producto en el que el usuario hizo clic. Una aplicación o proceso ETL que usa esos datos tendría que mapear estos mismos campos o atributos desde el sistema de origen (es decir, el flujo de datos de actividad del sitio Web) en el formato requerido por el sistema de destino. Si el sistema de destino fuese un sistema de gestión de relaciones con clientes, éste podría almacenar primero el nombre del usuario y el sello de la hora en quinto lugar; o bien podría no almacenar el producto seleccionado en absoluto. En este caso, una transformación para formatear la fecha en el formato esperado (y en el orden correcto) podría ocurrir entre la hora en que se leen los datos del origen y se escriben en el destino. |

| Scripts | ETL es un método de automatización de los scripts (conjunto de instrucciones) que se ejecutan detrás de escena para mover y transformar datos. Antes de ETL, los scripts se escribían de forma individual en lenguaje C o COBOL para transferir datos entre sistemas específicos. Esto daba como resultado que múltiples bases de datos ejecutaran numerosos scripts. Las primeras herramientas ETL se utilizaban en mainframes como proceso por lotes. ETL migró más tarde a las plataformas UNIX y de la PC. Hoy las organizaciones siguen utilizando scripts y métodos de movimiento de datos programáticos. |

| ETL versus ELT | En el principio, existía ETL. Después, las organizaciones agregaron ELT, que es un método complementario. ELT extrae datos de un sistema de origen, los carga en un sistema de destino y luego utiliza el poder de procesamiento del sistema de origen para realizar las transformaciones. Esto agiliza el procesamiento de datos porque sucede donde residen los datos. |

| Calidad de datos | Antes de que se integren los datos, a menudo se crea un área de preparación donde se pueden depurar datos, se pueden estandarizar valores de datos (CN y Carolina del Norte, Señor y Sr., o Matt y Matthew), se pueden verificar direcciones y se pueden eliminar duplicados. Muchas soluciones siguen siendo independientes, pero ahora se pueden ejecutar procedimientos de calidad de datos como una de las transformaciones en el proceso de integración de datos. |

| Programación y procesamiento | Las herramientas y tecnologías ETL pueden proporcionar capacidades de programación por lotes o en tiempo real. También pueden procesar datos en altos volúmenes en el servidor o pueden hacer descender el procesamiento al nivel de las bases de datos. Este enfoque de procesamiento en una base de datos en contraste con un motor especializado evita la duplicación de datos y la necesidad de utilizar capacidad extra en la plataforma de bases de datos. |

| Procesamiento por lotes | ETL suele referirse a un proceso por lotes de mover enormes volúmenes de datos entre dos sistemas durante lo que se conoce como una “ventana por lotes”. Durante este periodo de tiempo determinado – por ejemplo, entre las 12 y la 1 p.m. – no pueden llevarse a cabo acciones en el sistema de origen o de destino mientras se sincronizan datos. La mayoría de los bancos llevan a cabo un proceso por lotes nocturno para resolver transacciones que ocurren a lo lardo del día. |

| Servicios Web | Los servicios Web son un método basado en Internet de provisión de datos o funcionalidad a diversas aplicaciones casi en tiempo real. Este método simplifica procesos de integración de datos y puede generar más valor de los datos, en menos tiempo. Por ejemplo, supongamos que un cliente se pone en contacto con su centro de atención a clientes. Podría crear un servicio Web que devuelva el perfil completo del cliente con un tiempo de respuesta de menos de un segundo con tan sólo pasar un número de teléfono a un servicio Web que extrae los datos de múltiples fuentes o un concentrador MDM. Con un conocimiento más a fondo del cliente, el representante de atención a clientes puede tomar mejores decisiones acerca de cómo interactuar con dicho cliente. |

| Gestión de datos maestros | MDM es el proceso de conjuntar datos para crear una vista única de los datos a través de múltiples fuentes. Incluye capacidades ETL y de integración de datos para combinar los datos y crear un “registro de oro” o “el mejor registro”. |

| Virtualización de datos | La virtualización es un método ágil de combinar datos para crear una vista virtual de los datos sin moverlos. La virtualización de datos difiere de ETL, porque aunque se siguen realizando mapeo y unión de datos, no se necesita una tabla de preparación física para almacenar los resultados. Eso se debe a que la vista suele almacenarse en la memoria y alojarse en la caché para mejorar el desempeño. Algunas soluciones de virtualización de datos, como SAS Federation Server, proveen funciones dinámicas de enmascarado, aleatorias y mezcla de datos para proteger datos confidenciales de roles o grupos específicos. SAS proporciona también calidad de datos por demanda mientras se genera la vista. |

| Procesamiento de flujos de eventos y ETL | Cuando la velocidad de los datos aumenta a millones de eventos por segundo, se puede utilizar el procesamiento de flujos de eventos para monitorear flujos de datos, procesar los flujos de datos y ayudar a tomar decisiones más oportunas. Un ejemplo del espacio de la energía es el uso de la analítica predictiva en flujos de datos para detectar cuando una bomba sumergible necesita reparación para reducir las interrupciones de funcionamiento y el alcance y la magnitud del daño que sufre la bomba. |

Lea más acerca de este tema

-

Data quality management: What you need to knowData quality isn’t simply good or bad. Data quality management puts quality in context to improve fitness of the data you use for analysis and decision-making.

-

The importance of data quality: A sustainable approachBad data wrecks countless business ventures. Here’s a data quality plan to help you get it right.

-

Key questions to kick off your data analytics projectsThere’s no single blueprint for starting a data analytics project. Technology expert Phil Simon suggests these 10 questions as a guide.

-

¿Qué es un Data Lake y por qué es importante?Un Data Lake es un repositorio de almacenamiento que contiene grandes cantidades de datos en bruto en su formato nativo. Como contenedores de múltiples colecciones de datos en una ubicación conveniente, los Data Lakes permiten el acceso, la exploración y la visualización en modo autoservicio. Así, las empresas pueden ver y acceder a la nueva información más rápidamente.