ETL

Rôle et atouts

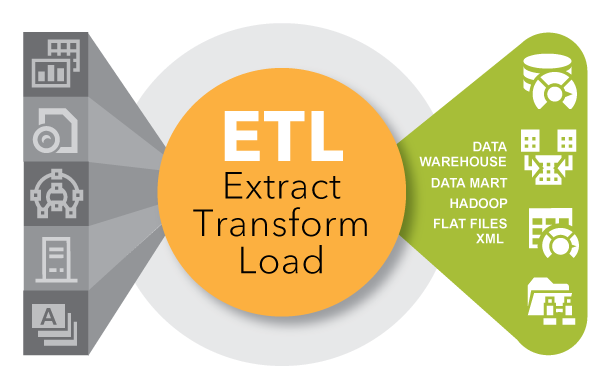

L'ETL est un type d'intégration des données qui fait référence aux trois étapes (extraction, transformation, chargement) utilisées pour mélanger des données provenant de sources multiples. Il est souvent utilisé pour construire un data warehouse. Au cours de ce processus, les données sont collectées (extraites) d'un système source, converties (transformées) dans un format qui peut être analysé, et stockées (chargées) dans un data warehouse ou un autre système. L'extraction, le chargement et la transformation (ELT) est une approche alternative mais connexe, conçue pour reporter le traitement au niveau de la base de données afin d'améliorer les performances.

Historique de l'ETL

L'ETL a gagné en popularité dans les années 1970 lorsque les organisations ont commencé à utiliser plusieurs référentiels de données, ou bases de données, pour stocker différents types d'informations commerciales. La nécessité d'intégrer les données réparties dans ces bases s'est rapidement imposée. L'ETL est devenu la méthode standard pour prendre des données de sources disparates et les transformer avant de les charger dans une source cible, ou destination.

À la fin des années 1980 et au début des années 1990, les data warehouses ont fait leur apparition. Type distinct de base de données, les data warehouses offrent un accès intégré aux données provenant de systèmes multiples – ordinateurs mainframe, mini-ordinateurs, ordinateurs personnels et feuilles de calcul. Mais souvent, différentes organisations choisissent des outils ETL différents utilisables avec des data warehouses différents. Avec les fusions et les acquisitions, de nombreuses entreprises se sont retrouvées avec plusieurs solutions ETL différentes qui n'étaient pas intégrées.

Au fil du temps, le nombre de formats, de sources et de systèmes de données s'est considérablement accru. Aujourd'hui, l'extraction, la transformation et le chargement n'est plus qu'une des nombreuses méthodes utilisées par les organisations pour collecter, importer et traiter les données. L'ETL et l'ELT sont tous les deux des composants importants de la stratégie élargie d'intégration des données d'une organisation.

Pourquoi est-ce important ?

Les entreprises s'appuient depuis de nombreuses années sur le processus ETL pour obtenir une vue consolidée des données qui leur permet de prendre de meilleures décisions. Aujourd'hui, cette méthode d'intégration des données provenant de systèmes et de sources multiples reste un élément essentiel de la boîte à outils d'intégration des données d'une organisation.

L'ETL est utilisé pour déplacer et transformer des données provenant de nombreuses sources différentes et les charger dans diverses cibles, comme Hadoop.

- Lorsqu'il est utilisé avec un data warehouse d'entreprise (données au repos), l'ETL fournit un contexte historique important pour l'entreprise.

- En fournissant une vue consolidée, l'ETL facilite l'analyse et le reporting des données pertinentes pour les initiatives des utilisateurs.

- L'ETL peut améliorer la productivité des professionnels des données car il codifie et réutilise les processus qui déplacent les données sans nécessiter de compétences techniques pour écrire du code ou des scripts.

- L'ETL a évolué au fil du temps pour prendre en charge les nouveaux besoins d'intégration, comme les données en continu.

- Les entreprises ont besoin à la fois de l'ETL et de l'ELT pour rassembler les données, conserver leur exactitude et fournir l'audit généralement requis pour l'entreposage des données, le reporting et l'Analytics.

L'ETL dans le monde d'aujourd'hui

Les données actuelles qui évoluent rapidement (données en continu, ou streaming data) peuvent être capturées et analysées à la volée grâce à l'analyse en continu. Cette approche offre la possibilité d'agir immédiatement, en fonction de ce qui se passe à un moment donné. Mais la vue historique offerte par l'ETL place les données dans leur contexte. En retour, les organisations obtiennent une compréhension complète de l'activité au fil du temps. Les deux approches doivent fonctionner ensemble.

7 Conseils pour Moderniser l'Intégration des Données

L'intégration des données existe depuis des années, mais elle joue encore un rôle essentiel dans la capture, le traitement et le déplacement des données. Suivez ces conseils de TDWI pour guider vos efforts de modernisation de l'intégration des données.

Accès rapide à une information de qualité

Les centres de renseignements sont détenus par les États ou les collectivités locales, mais ils accèdent aux informations relatives à la criminalité et aux menaces, les analysent et les partagent entre les partenaires locaux afin de détecter et de prévenir les activités criminelles et terroristes. Découvrez comment un centre de renseignement a utilisé SAS pour aider à protéger la sécurité nationale.

L'Intégration des Données Revisitée

Au lieu de disparaître, les anciennes technologies finissent souvent par coexister avec les nouvelles. Aujourd'hui, l'intégration des données évolue pour suivre le rythme des différents formats, sources et technologies de données. Ce document montre comment maintenir la pertinence de votre approche de l'intégration des données.

Les organisations les plus performantes auront mis en place une stratégie claire et précise qui reconnaît l'intégration des données comme une pierre angulaire fondamentale pour leur différenciation concurrentielle.

–David Loshin, Président de Knowledge Integrity Inc. The New Data Integration Landscape: Moving Beyond Ad Hoc ETL to an Enterprise Data Integration Strategy

Logiciel d'Intégration des Données de SAS

Le logiciel d'intégration de données de SAS distribue les tâches d'intégration sur n'importe quelle plate-forme et se connecte à quasiment n'importe quel stockage de données source ou cible.

Comment Utiliser l'ETL

Les outils ETL et ELT de base fonctionnent en tandem avec d'autres outils d'intégration de données, et avec divers autres aspects de la gestion des données – tels que la qualité des données, la gouvernance des données, la virtualisation et les métadonnées. Voici quelques utilisations courantes aujourd'hui :

ETL et utilisations traditionnelles

L'ETL est une méthode éprouvée sur laquelle de nombreuses organisations s'appuient tous les jours –comme les détaillants (retailers) qui ont besoin de consulter régulièrement les données relatives aux ventes, ou les prestataires de soins de santé qui cherchent à obtenir une représentation précise des demandes de remboursement. L'ETL permet de combiner et d'extraire les données de transaction d'un data warehouse ou d'un autre stockage de données afin qu'elles soient prêtes à être consultées par les professionnels dans un format qu'ils peuvent comprendre. L'ETL est également utilisé pour migrer les données des anciens systèmes vers des systèmes modernes avec des formats de données différents. Il est souvent utilisé pour consolider les données issues de fusions d'entreprises, et pour collecter et regrouper des données provenant de fournisseurs ou de partenaires externes.

ETL et Big Data – Transformations et Adaptateurs

Celui qui obtient le plus de données, c'est celui qui gagne. Bien que cela ne soit pas forcément vrai, le fait de pouvoir accéder facilement à un large éventail de données peut donner aux entreprises un avantage concurrentiel. Aujourd'hui, les entreprises ont besoin d'accéder à toutes sortes de big data – qu'il s'agisse de vidéos, de réseaux sociaux, de l'Internet of Things (IoT), des logs de serveurs, de données spatiales, de données ouvertes ou issue de crowdsourcing, etc. Les prestataires d'ETL modifient fréquemment leurs outils pour prendre en charge ces exigences émergentes et ces nouvelles sources de données. Les adaptateurs donnent accès à une énorme variété de sources de données, et les outils d'intégration de données interagissent avec ces adaptateurs pour extraire et charger les données de manière efficace.

ETL pour Hadoop – et plus encore

L'ETL a évolué pour prendre en charge l'intégration de bien plus que les traditionnels data warehouses. Les outils ETL avancés peuvent charger et convertir des données structurées et non structurées dans Hadoop. Ces outils lisent et écrivent plusieurs fichiers en parallèle depuis et vers Hadoop, simplifiant ainsi la manière dont les données sont fusionnées dans un processus de transformation commun. Certaines solutions intègrent des bibliothèques de transformations ETL pré-construites, à la fois pour les données de transaction et d'interaction qui fonctionnent sur Hadoop. L'ETL prend également en charge l'intégration entre les systèmes transactionnels, les stockages de données opérationnelles, les plate-formes BI, les hubs de Master Data Management (MDM) et le cloud.

ETL et accès aux données en libre-service

La préparation des données en libre-service est une tendance en plein essor qui donne aux utilisateurs métier et aux professionnels des données non techniques le pouvoir d'accéder, de mélanger et de transformer les données. Ad hoc par nature, cette approche accroît l'agilité organisationnelle et libère le service informatique de la contrainte de fournir des données dans différents formats pour les utilisateurs métier. On consacre alors moins de temps à la préparation des données et plus de temps à la génération d'informations. Par conséquent, les professionnels des données (qu'ils soient du métier ou de l'informatique) peuvent améliorer leur productivité, et les organisations peuvent intensifier leur utilisation des données pour prendre de meilleures décisions.

ETL et Qualité des Données

L'ETL et les autres outils d'intégration des données –utilisés pour le nettoyage, le profilage et l'audit des données – garantissent la fiabilité des données. Les outils ETL s'intègrent aux outils de qualité des données, et les prestataires d'ETL intègrent des outils connexes dans leurs solutions, tels que ceux utilisés pour la mise en correspondance des données et le lignage de données.

ETL et Métadonnées

Les métadonnées nous aident à comprendre le lignage des données (leur provenance) et leur impact sur les autres données de l'organisation. À mesure que les architectures de données deviennent plus complexes, il est important de suivre la manière dont les différents éléments de données de votre organisation sont utilisés et reliés. Par exemple, si vous ajoutez un nom de compte Twitter à votre base de données client, vous devez savoir ce qui sera affecté, comme les travaux ETL, les applications ou les rapports.

SAS® Data Management en pratique

Avec SAS Data Management, vous pouvez exploiter d'énormes volumes de données – par exemple, des données clients provenant de flux Twitter – pour obtenir des informations plus pertinentes que jamais. Matthew Magne explique comment SAS peut diffuser les données Twitter dans un data lake, nettoyer et profiler les données, puis révéler quels clients sont les plus susceptibles de partir. Ensuite, vous pouvez élaborer une stratégie pour les retenir.

Comment ça marche

L'ETL est étroitement lié à un certain nombre d'autres fonctions, processus et techniques d'intégration de données. En les comprenant bien, on peut avoir une vision plus claire du fonctionnement de l'ETL.

| SQL | "Structured query language" est la méthode la plus courante pour accéder aux données et les transformer dans une base de données. |

| Transformations, règles métier et adaptateurs | Après avoir extrait les données, l'ETL utilise des règles métier pour transformer les données dans de nouveaux formats. Les données transformées sont ensuite chargées dans la cible. |

| Mise en correspondance des données (Data mapping) | La mise en correspondance des données fait partie du processus de transformation. Le mapping fournit des instructions détaillées à une application sur la manière d'obtenir les données qu'elle doit traiter. Il décrit également quel champ source correspond à quel champ de destination. Par exemple, le troisième attribut d'un flux de données sur l'activité d'un site web peut être le nom de l'utilisateur, le quatrième peut être l'horodatage de cette activité et le cinquième peut être le produit sur lequel l'utilisateur a cliqué. Une application ou un processus ETL utilisant ces données devra faire correspondre ces mêmes champs ou attributs du système source (c'est-à-dire le flux de données sur l'activité du site web) au format requis par le système de destination. Si le système de destination est un système de gestion de la relation client, il peut stocker le nom de l'utilisateur en premier et l'horodatage en cinquième, et ne pas du tout stocker le produit sélectionné. Dans ce cas, entre le moment où les données sont lues depuis la source et celui où elles sont écrites sur la cible, une transformation doit avoir lieu pour formater la date dans le format attendu (et dans le bon ordre). |

| Scripts | L'ETL est une méthode d'automatisation des scripts (ensemble d'instructions) qui s'exécutent en arrière-plan pour déplacer et transformer les données. Avant l'ETL, les scripts étaient écrits individuellement en C ou COBOL pour transférer des données entre des systèmes spécifiques. Résultat, il existait de multiples bases de données exécutant de nombreux scripts. Les premiers outils ETL fonctionnaient sur des mainframes en tant que traitement par lots. L'ETL a ensuite migré vers les plate-formes UNIX et PC. Aujourd'hui, les organisations utilisent encore à la fois les scripts et les programmes de déplacement des données. |

| ETL vs ELT | Au début, il y avait l'ETL. Plus tard, les organisations ont ajouté les ELT, une méthode complémentaire. L'ELT extrait les données d'un système source, les charge dans un système de destination, puis utilise la puissance de traitement du système source pour effectuer les transformations. Cela permet d'accélérer le traitement des données, car celui-ci a lieu là où se trouvent les données. |

| Qualité des données | Avant l'intégration des données, on crée souvent une zone de transit où les données peuvent être nettoyées, où les valeurs des données peuvent être normalisées (IDF et Ile-de-France, Monsieur et M., ou Fred et Frédéric), où les adresses peuvent être vérifiées et où les doublons peuvent être supprimés. De nombreuses solutions sont encore autonomes, mais les procédures de qualité des données peuvent désormais être exécutées comme l'une des transformations du processus d'intégration des données. |

| Ordonnancement et traitement | Les outils et technologies ETL peuvent fournir des capacités d'ordonnancement par lots ou en temps réel. Ils peuvent également traiter de grand volumes de données dans le serveur, ou bien reléguer le traitement au niveau de la base de données. Cette approche du traitement dans une base de données, par opposition à un moteur spécialisé, prévient la duplication des données et évite de devoir utiliser des moyens supplémentaires sur la plate-forme de la base de données. |

| Traitement par lots | L'ETL fait généralement référence à un traitement par lots consistant à déplacer d'énormes volumes de données entre deux systèmes pendant ce que l'on appelle une "fenêtre de traitement par lots". Pendant cette période déterminée – disons entre midi et 13 heures – aucune action ne peut être effectuée sur les systèmes source et cible puisque les données se synchronisent. La plupart des banques effectuent un traitement par lots pendant la nuit pour résoudre les transactions qui ont lieu dans la journée. |

| Services Web | Les services web sont une méthode basée sur internet pour fournir des données ou des fonctionnalités à diverses applications quasiment en temps réel. Cette méthode simplifie les processus d'intégration des données et permet de tirer davantage de valeur des données, plus rapidement. Par exemple, imaginons qu'un client contacte votre centre d'appels. Vous pouvez créer un service web qui renvoie le profil complet du client avec un temps de réponse inférieur à une seconde, en transmettant simplement un numéro de téléphone à un service web qui extrait les données de plusieurs sources ou d'un hub MDM. Grâce à une meilleure connaissance du client, le représentant du service clientèle peut prendre de meilleures décisions sur la manière d'interagir avec le client. |

| Master Data Management (MDM) | Le MDM est le processus qui consiste à rassembler les données pour créer une vue unique des données provenant de sources multiples. Il comprend à la fois des fonctionnalités d'ETL et d'intégration de données pour mélanger les données et créer un "golden record" ou "point unique de vérité". |

| Virtualisation des données | La virtualisation est une méthode agile qui consiste à mélanger des données pour créer une vue virtuelle des données sans les déplacer. La virtualisation des données diffère de l'ETL, car même si le mapping et le regroupement des données ont lieu, elle ne nécessite pas de disposer d'une table intermédiaire physique pour stocker les résultats. Cela s'explique par le fait que la vue est souvent stockée en mémoire et mise en cache pour améliorer les performances. Certaines solutions de virtualisation des données, comme SAS Federation Server, fournissent des fonctions de masquage dynamique, de randomisation et de hachage des données afin de protéger les données sensibles contre des rôles ou des groupes spécifiques. SAS assure également la qualité des données sur demande pendant que la vue est générée. |

| Event stream processing et ETL | Lorsque la vitesse des données monte jusqu'à des millions d'événements par seconde, l'event stream processing peut être utilisé pour surveiller les flux de données, les traiter et aider à prendre des décisions plus opportunes. Par exemple, dans le domaine de l'énergie, on peut utiliser l'analyse prédictive sur des flux de données pour détecter quand une pompe immergée a besoin d'être réparée, afin de réduire à la fois les temps d'arrêt mais aussi l'étendue et la taille des dommages. |

En savoir plus sur l'analyse prédictive

- Key questions to kick off your data analytics projectsThere’s no single blueprint for starting a data analytics project. Technology expert Phil Simon suggests these 10 questions as a guide.

- Data lake : Présentation et atoutsUn data lake est un type de référentiel de stockage qui ingère rapidement de grandes quantités de données brutes et hétérogènes dans leur format natif. Les data lakes contiennent tout type de données, de plusieurs sources en un seul référentiel et permettent un accès, une exploration et une visualisation en libre-service. Les entreprises peuvent ainsi voir et réagir plus rapidement à de nouvelles informations.

- 5 data management best practices to help you do data rightFollow these 5 data management best practices to make sure your business data gives you great results from analytics.

- Data lineage: Making artificial intelligence smarterLear how data lineage plays a vital role in understanding data, making it a foundational principle of AI.